การถือกำเนิดของคอมพิวเตอร์ควอนตัมที่มีความสามารถสูง หรือ Cryptographically Relevant Quantum Computers (CRQCs) กำลังจะกลายเป็นภัยคุกคามร้ายแรงต่อโครงสร้างพื้นฐานกุญแจสาธารณะ (Public Key Infrastructure – PKI) ที่ใช้งานอยู่ในปัจจุบัน. ระบบการเข้ารหัสแบบกุญแจอสมมาตรที่ใช้กันอย่างแพร่หลาย เช่น RSA และ Elliptic Curve Cryptography (ECC) ซึ่งเป็นรากฐานความปลอดภัยของการสื่อสารดิจิทัลและการทำธุรกรรมออนไลน์จำนวนมาก อาศัยความยากทางคณิตศาสตร์ในการแยกตัวประกอบจำนวนเต็มขนาดใหญ่ (Integer Factorization) และการแก้ปัญหาลอการิทึมแบบไม่ต่อเนื่อง (Discrete Logarithm Problem – DLP) ตามลำดับ. อย่างไรก็ตาม อัลกอริทึมควอนตัมที่ชื่อว่า Shor’s algorithm สามารถแก้ปัญหาเหล่านี้ได้อย่างรวดเร็วในเวลาพหุนาม (polynomial time) ด้วยคอมพิวเตอร์ควอนตัม ทำให้ระบบ RSA และ ECC ไม่ปลอดภัยอีกต่อไป

ในขณะเดียวกัน อัลกอริทึมควอนตัมอีกตัวหนึ่งคือ Grover’s algorithm ก็ส่งผลกระทบต่อการเข้ารหัสแบบสมมาตร (Symmetric Cryptography) เช่น Advanced Encryption Standard (AES) โดยลดทอนความแข็งแกร่งของกุญแจลงครึ่งหนึ่งในทางทฤษฎี. แม้ว่าผลกระทบนี้จะรุนแรงน้อยกว่าภัยคุกคามต่อ PKI แต่ก็จำเป็นต้องปรับเพิ่มความยาวกุญแจเพื่อรักษาความปลอดภัยในระดับเดิม

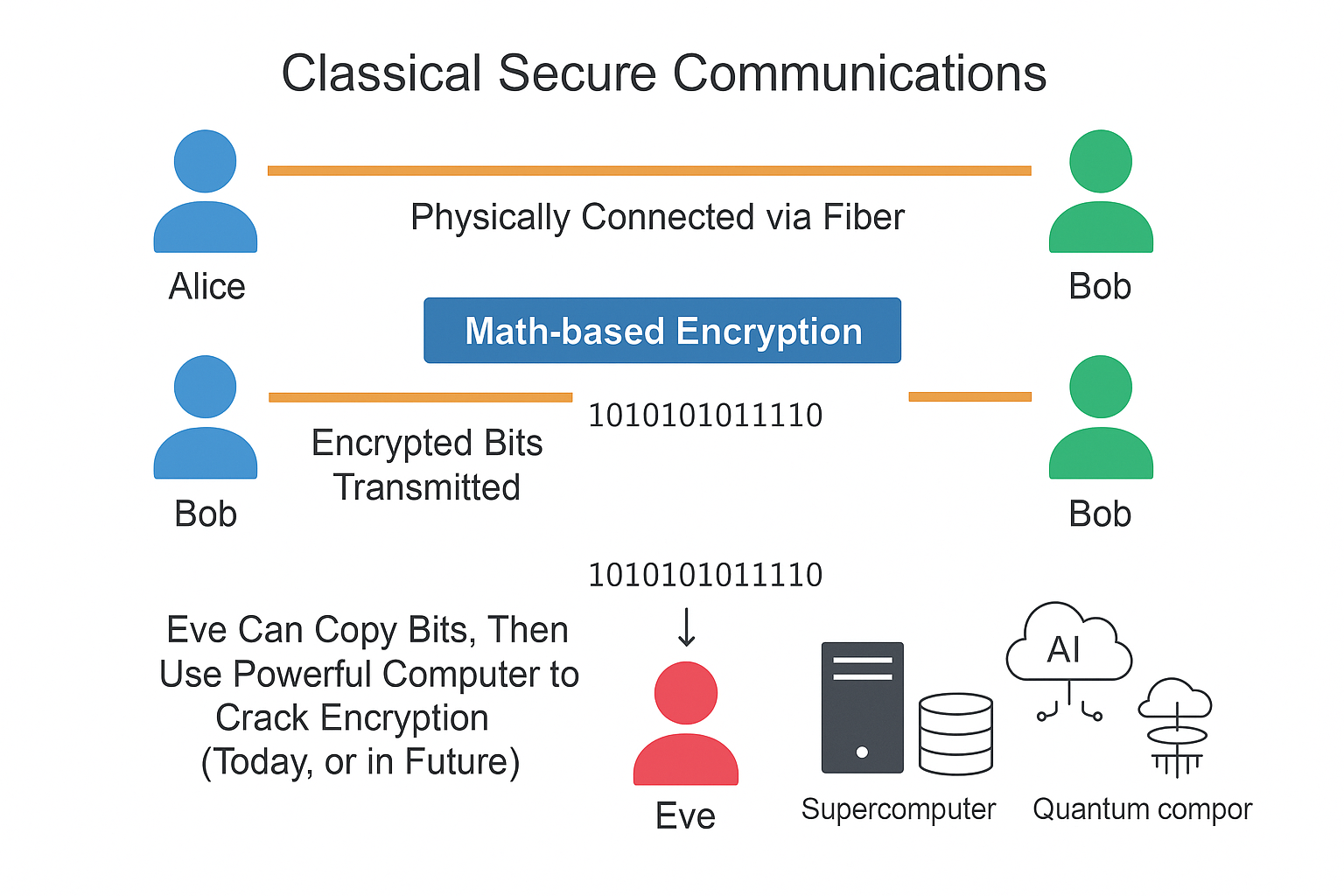

ภัยคุกคามเหล่านี้ยิ่งทวีความรุนแรงขึ้นจากแนวคิด “Harvest Now, Decrypt Later” (HNDL) ซึ่งผู้ไม่ประสงค์ดีทำการดักจับและจัดเก็บข้อมูลที่เข้ารหัสในปัจจุบันไว้ เพื่อรอถอดรหัสในอนาคตเมื่อ CRQCs พร้อมใช้งาน. กลยุทธ์นี้ทำให้ข้อมูลที่ต้องการการปกป้องในระยะยาวมีความเสี่ยงทันที แม้ว่า CRQCs จะยังไม่เกิดขึ้นจริงก็ตาม

เพื่อรับมือกับภัยคุกคามนี้ การเปลี่ยนผ่านไปสู่การเข้ารหัสลับหลังยุคควอนตัม (Post-Quantum Cryptography – PQC) หรือการเข้ารหัสที่ทนทานต่อควอนตัม (Quantum-Resistant Cryptography) จึงเป็นสิ่งจำเป็นเร่งด่วน. สถาบันมาตรฐานและเทคโนโลยีแห่งชาติสหรัฐฯ (NIST) ได้ริเริ่มโครงการ PQC Standardization เพื่อคัดเลือกและออกมาตรฐานอัลกอริทึม PQC ที่ปลอดภัยและใช้งานได้จริง. ในเดือนสิงหาคม 2024 NIST ได้เผยแพร่มาตรฐานชุดแรก ได้แก่ ML-KEM (Kyber) สำหรับการห่อหุ้มกุญแจ (Key Encapsulation), ML-DSA (Dilithium) และ SLH-DSA (SPHINCS+) สำหรับลายเซ็นดิจิทัล.

องค์กรต่างๆ จำเป็นต้องเตรียมความพร้อมสำหรับการเปลี่ยนผ่านนี้โดยทันที ข้อเสนอแนะเชิงกลยุทธ์ที่สำคัญ ได้แก่ การเริ่มต้นทำบัญชีรายการสินทรัพย์การเข้ารหัส (Cryptographic Inventory) และการประเมินความเสี่ยงควอนตัม การวางแผนโดยคำนึงถึงความคล่องตัวในการเข้ารหัส (Crypto-Agility) เพื่อรองรับการเปลี่ยนแปลงในอนาคต การพิจารณาใช้แนวทางการเข้ารหัสแบบผสมผสาน (Hybrid Cryptography) เป็นมาตรการชั่วคราว การติดตามและปฏิบัติตามมาตรฐาน PQC ที่ประกาศใช้ และการใช้ประโยชน์จากเครื่องมือโอเพนซอร์ส เช่น Open Quantum Safe (OQS) เพื่อการทดลองและทดสอบ. การดำเนินการเชิงรุกและการวางแผนอย่างรอบคอบเป็นกุญแจสำคัญในการรักษาความปลอดภัยของข้อมูลในยุคควอนตัมที่กำลังจะมาถึง

1. ภัยคุกคามควอนตัมต่อการเข้ารหัสลับ (The Looming Quantum Threat to Cryptography)

1.1. พื้นฐานคอมพิวเตอร์ควอนตัมและความเกี่ยวข้องกับการเข้ารหัสลับ (Quantum Computing Fundamentals and Cryptographic Relevance)

คอมพิวเตอร์ควอนตัมเป็นเครื่องคำนวณรูปแบบใหม่ที่ใช้ประโยชน์จากปรากฏการณ์ทางกลศาสตร์ควอนตัมเพื่อแก้ปัญหาทางคณิตศาสตร์บางประเภทที่คอมพิวเตอร์แบบดั้งเดิม (Classical Computer) ไม่สามารถทำได้ หรือทำได้ช้ามาก. หน่วยประมวลผลพื้นฐานของคอมพิวเตอร์ควอนตัมคือ คิวบิต (qubit) ซึ่งแตกต่างจากบิต (bit) ของคอมพิวเตอร์ดั้งเดิมที่แทนสถานะได้เพียง 0 หรือ 1 เท่านั้น คิวบิตสามารถอยู่ในสถานะซ้อนทับ (superposition) ของทั้ง 0 และ 1 ได้พร้อมกัน (∣ψ⟩=α∣0⟩+β∣1⟩ โดยที่ ∣α∣2+∣β∣2=1). นอกจากนี้ คิวบิตยังสามารถมีความพัวพัน (entanglement) ซึ่งหมายความว่าสถานะของคิวบิตหนึ่งสามารถเชื่อมโยงกับสถานะของคิวบิตอื่นได้ แม้จะอยู่ห่างกันก็ตาม

คุณสมบัติเหล่านี้ โดยเฉพาะอย่างยิ่งการซ้อนทับและความพัวพัน ทำให้คอมพิวเตอร์ควอนตัมสามารถทำการคำนวณแบบขนาน (quantum parallelism) ได้ในระดับที่ไม่เคยมีมาก่อน. อย่างไรก็ตาม สิ่งสำคัญคือต้องเข้าใจว่าคอมพิวเตอร์ควอนตัมไม่ใช่เครื่องเร่งความเร็วสำหรับงานคำนวณทุกประเภท แต่เป็นเครื่องจักรสำหรับวัตถุประสงค์พิเศษ (special-purpose machines) ที่มีความสามารถโดดเด่นในการแก้ปัญหาเฉพาะบางอย่างเท่านั้น โดยเฉพาะปัญหาที่มีโครงสร้างทางคณิตศาสตร์ที่เหมาะสมกับอัลกอริทึมควอนตัม

ความเกี่ยวข้องที่สำคัญที่สุดของคอมพิวเตอร์ควอนตัมกับการเข้ารหัสลับคือ ความสามารถในการทำลายความปลอดภัยของระบบการเข้ารหัสที่ใช้กันอย่างแพร่หลายในปัจจุบัน. อัลกอริทึมควอนตัม เช่น Shor’s algorithm และ Grover’s algorithm ใช้ประโยชน์จากหลักการควอนตัมเพื่อแก้ปัญหาทางคณิตศาสตร์ที่เป็นรากฐานของความปลอดภัยในการเข้ารหัสแบบอสมมาตรและสมมาตรตามลำดับ ได้เร็วกว่าอัลกอริทึมที่ดีที่สุดที่ทราบสำหรับคอมพิวเตอร์ดั้งเดิมอย่างมาก

เพื่อประเมินภัยคุกคามนี้อย่างเป็นรูปธรรม จึงมีการนิยามคำว่า “Cryptographically Relevant Quantum Computer” (CRQC) ขึ้น หมายถึง คอมพิวเตอร์ควอนตัมที่มีขนาด (จำนวนคิวบิต) และความทนทานต่อความผิดพลาด (fault tolerance) เพียงพอที่จะทำลายการเข้ารหัสแบบกุญแจสาธารณะที่ใช้ในปัจจุบันได้ โดยหลักแล้วคือการใช้อัลกอริทึมของ Shor. การสร้าง CRQC ยังคงเป็นความท้าทายทางวิศวกรรมที่สำคัญ เนื่องจากต้องใช้คิวบิตจำนวนมากที่มีความเสถียรสูงและมีระยะเวลาการรักษาคุณสมบัติควอนตัม (coherence time) ที่ยาวนานพอ. อย่างไรก็ตาม ความก้าวหน้าในการวิจัยและพัฒนาคอมพิวเตอร์ควอนตัมในช่วงไม่กี่ปีที่ผ่านมา ทำให้หลายฝ่ายเชื่อว่าการสร้าง CRQC เป็นไปได้ในอนาคตอันใกล้

ความสามารถที่โดดเด่นของคอมพิวเตอร์ควอนตัมไม่ได้อยู่ที่การเร่งความเร็วการคำนวณทุกประเภท แต่เป็นการแก้ปัญหาเฉพาะทางบางอย่างได้อย่างมีประสิทธิภาพเหนือกว่าคอมพิวเตอร์แบบดั้งเดิมอย่างมหาศาล ปัญหาเหล่านี้รวมถึงการแยกตัวประกอบจำนวนเต็มขนาดใหญ่ และการแก้ปัญหาลอการิทึมแบบไม่ต่อเนื่อง ซึ่งเป็นหัวใจสำคัญของความปลอดภัยในการเข้ารหัสแบบกุญแจสาธารณะ (Public Key Infrastructure – PKI) นอกจากนี้ยังรวมถึงปัญหาการค้นหาข้อมูลในฐานข้อมูลที่ไม่มีการเรียงลำดับ ซึ่งส่งผลกระทบต่อความปลอดภัยของการเข้ารหัสแบบสมมาตร ความเฉพาะเจาะจงของภัยคุกคามนี้จึงเป็นเหตุผลหลักที่ทำให้การพัฒนาและการเปลี่ยนผ่านไปสู่ Post-Quantum Cryptography (PQC) มุ่งเน้นไปที่การปกป้องระบบกุญแจสาธารณะเป็นอันดับแรก.

1.2. Shor’s Algorithm: การเจาะระบบการเข้ารหัสแบบกุญแจอสมมาตร (RSA, ECC) (Shor’s Algorithm: Breaking Asymmetric Cryptography)

อัลกอริทึมของ Shor ซึ่งพัฒนาโดย Peter Shor ในปี 1994 ถือเป็นหนึ่งในความก้าวหน้าที่สำคัญที่สุดในสาขาคอมพิวเตอร์ควอนตัม และเป็นสาเหตุหลักของความกังวลเกี่ยวกับความปลอดภัยของการเข้ารหัสลับในยุคควอนตัม. อัลกอริทึมนี้มีความสามารถในการแก้ปัญหาทางคณิตศาสตร์สองประเภทที่สำคัญ ได้แก่ การแยกตัวประกอบจำนวนเต็ม (integer factorization) และการแก้ปัญหาลอการิทึมแบบไม่ต่อเนื่อง (Discrete Logarithm Problem – DLP) ได้อย่างมีประสิทธิภาพบนคอมพิวเตอร์ควอนตัม.

ความสามารถนี้ส่งผลกระทบโดยตรงต่อความปลอดภัยของระบบการเข้ารหัสแบบกุญแจอสมมาตรที่ใช้กันอย่างแพร่หลายที่สุดในปัจจุบัน:

- RSA (Rivest–Shamir–Adleman): ความปลอดภัยของ RSA ขึ้นอยู่กับความยากในการแยกตัวประกอบของจำนวนเต็มขนาดใหญ่ N ซึ่งเป็นผลคูณของจำนวนเฉพาะสองตัว p และ q. คอมพิวเตอร์แบบดั้งเดิมต้องใช้เวลาในระดับเอ็กซ์โพเนนเชียล (exponential time) ในการแยกตัวประกอบ N ที่มีขนาดใหญ่พอ (เช่น 2048 บิต) ทำให้การโจมตีด้วยวิธีนี้เป็นไปไม่ได้ในทางปฏิบัติ (มีการประมาณว่าอาจใช้เวลาถึง 300 ล้านล้านปี). อย่างไรก็ตาม Shor’s algorithm สามารถแยกตัวประกอบ N ได้ในเวลาพหุนาม (polynomial time) หรือ O((logN)3) บนคอมพิวเตอร์ควอนตัมในอุดมคติ ทำให้ RSA ไม่ปลอดภัยอีกต่อไป.

- ECC (Elliptic Curve Cryptography): รวมถึงโปรโตคอลที่เกี่ยวข้อง เช่น ECDH (Elliptic Curve Diffie–Hellman) และ ECDSA (Elliptic Curve Digital Signature Algorithm) ความปลอดภัยของ ECC อาศัยความยากในการแก้ปัญหาลอการิทึมแบบไม่ต่อเนื่องบนเส้นโค้งวงรี (Elliptic Curve Discrete Logarithm Problem – ECDLP). Shor’s algorithm สามารถปรับใช้เพื่อแก้ปัญหา ECDLP ได้อย่างมีประสิทธิภาพเช่นกัน.

กลไกหลักของ Shor’s algorithm คือการลดรูปปัญหาการแยกตัวประกอบหรือ DLP ไปเป็นปัญหาการหาคาบ (period-finding) ของฟังก์ชันทางคณิตศาสตร์ที่เกี่ยวข้อง. ตัวอย่างเช่น ในกรณีของ RSA ขั้นตอนแรกคือการเลือกจำนวนเต็มสุ่ม a และหา “อันดับ” (order) r ของ a มอดุโล N ซึ่งคือจำนวนเต็มบวกที่น้อยที่สุดที่ทำให้ ar≡1(modN). การหาค่า r นี้เป็นส่วนที่คอมพิวเตอร์ควอนตัมเข้ามามีบทบาทสำคัญ โดยใช้เทคนิคที่เรียกว่า Quantum Phase Estimation (QPE) ซึ่งอาศัย Quantum Fourier Transform (QFT) เป็นองค์ประกอบหลักในการวิเคราะห์สเปกตรัมของสถานะควอนตัมเพื่อหาคาบดังกล่าวได้อย่างรวดเร็ว. อัลกอริทึมยังใช้ประโยชน์จากการยกกำลังมอดุลาร์ (modular exponentiation) และการคำนวณแบบขนานควอนตัม (quantum parallelism) เพื่อทดสอบค่าที่เป็นไปได้จำนวนมากพร้อมกัน. เมื่อได้ค่า r แล้ว หาก r เป็นเลขคู่และ ar/2≡−1(modN) ก็สามารถหาตัวประกอบของ N ได้โดยการคำนวณตัวหารร่วมมาก (gcd) ของ (ar/2−1) กับ N และ (ar/2+1) กับ N.

การประเมินทรัพยากรที่จำเป็นสำหรับการรัน Shor’s algorithm เพื่อทำลายการเข้ารหัสจริงยังคงเป็นประเด็นที่ศึกษาอย่างต่อเนื่อง มีการประมาณการว่าการทำลายคีย์ ECC ขนาด 256 บิต อาจต้องใช้คิวบิตประมาณ 2,500 คิวบิต ในขณะที่การทำลายคีย์ RSA ขนาด 2048 บิต อาจต้องใช้ประมาณ 4,000 คิวบิต. การศึกษาอื่นประเมินว่าการแก้ ECDLP บนฟิลด์เฉพาะ n บิต อาจต้องการคิวบิตประมาณ 9n+2⌈log2(n)⌉+10 คิวบิต และเกต Toffoli จำนวนมากถึง 448n3log2(n)+4090n3. ตัวเลขเหล่านี้ชี้ให้เห็นว่า ECC ซึ่งมีข้อได้เปรียบในด้านประสิทธิภาพ (ขนาดคีย์เล็กกว่า RSA สำหรับระดับความปลอดภัยคลาสสิกที่เท่ากัน) อาจกลายเป็นเป้าหมายที่ง่ายกว่าสำหรับคอมพิวเตอร์ควอนตัมเมื่อเทียบกับ RSA. ข้อได้เปรียบด้านขนาดคีย์ที่เล็กของ ECC ในโลกคลาสสิก กลับกลายเป็นจุดอ่อนในยุคควอนตัม เนื่องจากจำนวนคิวบิตที่น้อยลงหมายถึงความซับซ้อนที่ลดลงในการโจมตีด้วยควอนตัม อย่างไรก็ตาม การสร้างคอมพิวเตอร์ควอนตัมที่ทนทานต่อความผิดพลาด (fault-tolerant) ซึ่งมีคิวบิตคุณภาพสูงจำนวนมากและมี coherence time ที่ยาวนานพอ ยังคงเป็นอุปสรรคทางเทคโนโลยีที่สำคัญ

1.3. Grover’s Algorithm: การลดทอนความปลอดภัยของการเข้ารหัสแบบสมมาตร (AES) (Grover’s Algorithm: Weakening Symmetric Cryptography)

ในขณะที่ Shor’s algorithm เป็นภัยคุกคามต่อการเข้ารหัสแบบกุญแจอสมมาตร Grover’s algorithm ซึ่งพัฒนาโดย Lov Grover ในปี 1996 ส่งผลกระทบต่อการเข้ารหัสแบบสมมาตร (symmetric key cryptography) เช่น AES. อัลกอริทึมของ Grover จัดอยู่ในกลุ่มอัลกอริทึมการค้นหาควอนตัม (quantum search algorithm) ที่สามารถเร่งความเร็วการค้นหาในฐานข้อมูลที่ไม่มีการเรียงลำดับ (unstructured search) ได้อย่างมีนัยสำคัญ

โดยปกติแล้ว การค้นหาข้อมูลเป้าหมายในรายการขนาด N ที่ไม่มีการจัดเรียง คอมพิวเตอร์แบบดั้งเดิมจะต้องทำการตรวจสอบโดยเฉลี่ย N/2 ครั้ง หรือ N ครั้งในกรณีที่แย่ที่สุด. แต่ Grover’s algorithm สามารถค้นหารายการเป้าหมายได้โดยใช้การสอบถาม (query) ไปยัง “oracle” (ฟังก์ชันที่ระบุว่าข้อมูลที่กำลังพิจารณาใช่เป้าหมายหรือไม่) เพียงประมาณ 4πN ครั้งเท่านั้น. การเร่งความเร็วแบบกำลังสอง (quadratic speedup) นี้ แม้จะไม่ใช่การเร่งความเร็วแบบเอ็กซ์โพเนนเชียลเหมือน Shor’s algorithm แต่ก็มีนัยสำคัญอย่างยิ่งสำหรับปัญหาการค้นหาขนาดใหญ่

ผลกระทบโดยตรงต่อการเข้ารหัสแบบสมมาตรคือการโจมตีแบบค้นหากุญแจ (key recovery attack). การค้นหากุญแจลับขนาด n บิต ด้วยวิธี brute-force บนคอมพิวเตอร์ดั้งเดิมจะต้องลองกุญแจที่เป็นไปได้ทั้งหมดประมาณ 2n ครั้ง. แต่ด้วย Grover’s algorithm ความซับซ้อนนี้จะลดลงเหลือประมาณ 2n/2 ครั้ง. ตัวอย่างเช่น การทำลาย AES-128 (กุญแจ 128 บิต) ด้วยวิธีดั้งเดิมต้องใช้ 2128 การดำเนินการ แต่ Grover’s algorithm ลดเหลือเพียง 264 การดำเนินการในทางทฤษฎี. กล่าวอีกนัยหนึ่ง Grover’s algorithm ลดทอนความแข็งแกร่งของกุญแจสมมาตรลงครึ่งหนึ่ง.

เพื่อรับมือกับภัยคุกคามนี้ ชุมชนการเข้ารหัสลับได้เสนอแนวทางแก้ไขที่ค่อนข้างตรงไปตรงมา คือการเพิ่มความยาวของกุญแจเป็นสองเท่า. ตัวอย่างเช่น การเปลี่ยนไปใช้ AES-256 (กุญแจ 256 บิต) แทน AES-128 จะทำให้ความซับซ้อนของการโจมตีด้วย Grover’s algorithm เพิ่มขึ้นเป็น 2256/2=2128 ซึ่งถือว่าเพียงพอที่จะรักษาความปลอดภัยในระดับที่ยอมรับได้ในปัจจุบัน. NIST เองก็แนะนำให้ใช้ AES-256 เพื่อต้านทานการโจมตีด้วยควอนตัม

อย่างไรก็ตาม การประเมินภัยคุกคามจาก Grover’s algorithm เพียงแค่พิจารณาจำนวนการสอบถาม (query cost) อาจทำให้เข้าใจผิดได้. การนำ Grover’s algorithm มาใช้จริงเพื่อทำลายการเข้ารหัสที่แข็งแกร่งอย่าง AES นั้นต้องเผชิญกับต้นทุนและความท้าทายในทางปฏิบัติอย่างมหาศาล :

- การสร้างวงจรควอนตัม: ต้องสร้างวงจรควอนตัมแบบย้อนกลับได้ (reversible quantum circuit) สำหรับอัลกอริทึมการเข้ารหัสสมมาตร (เช่น การทำงานของ S-box และ key schedule ใน AES) ซึ่งเป็นเรื่องซับซ้อนและต้องใช้ทรัพยากร (คิวบิตและเกต) จำนวนมาก. มีงานวิจัยจำนวนมากที่พยายามลดขนาดและทรัพยากรของวงจรเหล่านี้.

- ต้นทุนการแก้ไขข้อผิดพลาดควอนตัม (QEC): การคำนวณด้วยควอนตัมมีความอ่อนไหวต่อสัญญาณรบกวน (noise) และข้อผิดพลาด (errors) การรัน Grover’s algorithm ที่ต้องทำซ้ำหลายรอบจำเป็นต้องมี QEC ที่มีประสิทธิภาพสูง ซึ่งเพิ่มค่าใช้จ่ายด้านทรัพยากรทางกายภาพ (physical qubits) อย่างมาก.

- ประสิทธิภาพการทำงานแบบขนาน: Grover’s algorithm ไม่สามารถขนาน (parallelize) ได้อย่างมีประสิทธิภาพเหมือนการค้นหาแบบดั้งเดิม การลดเวลาการทำงานลง S เท่า จำเป็นต้องใช้หน่วยประมวลผลควอนตัมแบบขนานถึง S2 ตัว ทำให้การเร่งความเร็วอย่างมีนัยสำคัญด้วยการขนานมีต้นทุนสูงมาก.

- ข้อจำกัดด้านความลึกของวงจร: คอมพิวเตอร์ควอนตัมในปัจจุบันและอนาคตอันใกล้มีข้อจำกัดด้านความลึกสูงสุดของวงจร (จำนวนการดำเนินการต่อเนื่อง) ที่สามารถรันได้อย่างน่าเชื่อถือ การรัน Grover’s algorithm สำหรับคีย์ขนาดใหญ่อาจต้องการความลึกของวงจรที่เกินขีดจำกัดนี้.

ด้วยเหตุผลเหล่านี้ แม้ว่า Grover’s algorithm จะลดทอนความปลอดภัยทางทฤษฎีของการเข้ารหัสแบบสมมาตรลงครึ่งหนึ่ง แต่ต้นทุนและทรัพยากรที่ต้องใช้ในการโจมตี AES-256 ในทางปฏิบัติยังคงสูงมาก และอาจสูงกว่าทรัพยากรที่จำเป็นสำหรับ Shor’s algorithm ในการทำลาย RSA หรือ ECC อย่างมีนัยสำคัญ. การประเมินหนึ่งชี้ว่า Shor’s algorithm อาจทำลาย PKI ได้ในเวลาไม่กี่ชั่วโมงบน CRQC เครื่องเดียว ในขณะที่ Grover’s algorithm อาจต้องใช้เวลาหลายพันล้านปีบนเครื่องขนาดเดียวกันเพื่อทำลายคีย์สมมาตร. ดังนั้น ผลกระทบหลักของ Grover’s algorithm คือการกระตุ้นให้เกิดการเปลี่ยนไปใช้กุญแจสมมาตรที่มีความยาวมากขึ้น (เช่น AES-256) แทนที่จะทำให้การเข้ารหัสแบบสมมาตรหมดความน่าเชื่อถือไปโดยสิ้นเชิง.

ตารางที่ 1: เปรียบเทียบการโจมตีแบบดั้งเดิมและแบบควอนตัมต่อระบบการเข้ารหัสลับ

| ประเภทการเข้ารหัส | พื้นฐานความปลอดภัย | ความซับซ้อนการโจมตีแบบดั้งเดิม | อัลกอริทึมควอนตัมที่เกี่ยวข้อง | ความซับซ้อนการโจมตีแบบควอนตัม | ผลกระทบจากควอนตัม |

|---|---|---|---|---|---|

| กุญแจอสมมาตร (RSA, ECC) | ความยากในการแยกตัวประกอบ / แก้ DLP | เอ็กซ์โพเนนเชียล | Shor’s Algorithm | พหุนาม (O(log3N)) | ถูกทำลาย (Broken) |

| กุญแจสมมาตร (AES) | ความยากในการค้นหากุญแจ (Key Exhaustion) | เอ็กซ์โพเนนเชียล (O(2n)) | Grover’s Algorithm | ลดลงแบบกำลังสอง (O(2n/2)) | ต้องเพิ่มความยาวกุญแจเป็นสองเท่า |

| ฟังก์ชันแฮช (SHA-2, SHA-3) | ความต้านทานการหาค่า Preimage / Collision | O(2n) / O(2n/2) | Grover’s Algorithm (สำหรับ Preimage) | ลดลงแบบกำลังสอง (O(2n/2) สำหรับ Preimage) | อาจต้องเพิ่มขนาด Output |

Export to Sheets

หมายเหตุ: N คือจำนวนที่ต้องการแยกตัวประกอบ หรือขนาดของกลุ่มใน DLP; n คือความยาวบิตของกุญแจ หรือขนาด Output ของฟังก์ชันแฮช

ตารางนี้สรุปให้เห็นภาพรวมที่ชัดเจนว่าผลกระทบของคอมพิวเตอร์ควอนตัมต่อการเข้ารหัสประเภทต่างๆ นั้นแตกต่างกันอย่างมีนัยสำคัญ การเข้ารหัสแบบกุญแจอสมมาตรเผชิญกับภัยคุกคามระดับ存亡 (existential threat) จาก Shor’s algorithm ที่เปลี่ยนความซับซ้อนจากเอ็กซ์โพเนนเชียลเป็นพหุนาม ในขณะที่การเข้ารหัสแบบสมมาตรเพียงแค่ถูกลดทอนความแข็งแกร่งลง ซึ่งสามารถแก้ไขได้โดยการเพิ่มความยาวกุญแจ ส่วนฟังก์ชันแฮชได้รับผลกระทบน้อยที่สุด นี่คือเหตุผลที่ความพยายามในการพัฒนา PQC จึงมุ่งเน้นไปที่การทดแทนระบบกุญแจอสมมาตรเป็นหลัก

1.4. “Harvest Now, Decrypt Later” (HNDL): ภัยคุกคามเงียบ (The Silent Threat)

นอกเหนือจากภัยคุกคามโดยตรงจากอัลกอริทึมควอนตัมแล้ว ยังมีกลยุทธ์การโจมตีทางไซเบอร์ที่น่ากังวลอีกรูปแบบหนึ่งซึ่งเกี่ยวข้องกับอนาคตของคอมพิวเตอร์ควอนตัม นั่นคือ “Harvest Now, Decrypt Later” (HNDL) หรือที่เรียกว่า “retrospective decryption” หรือ “store now, decrypt later”. แนวคิดหลักของ HNDL คือการที่ผู้ไม่ประสงค์ดี (เช่น หน่วยงานข่าวกรองของรัฐ หรือกลุ่มอาชญากรไซเบอร์ที่มีทรัพยากรสูง) ทำการดักจับและรวบรวมข้อมูลที่เข้ารหัสไว้ในปัจจุบัน แม้ว่าจะยังไม่สามารถถอดรหัสได้ด้วยเทคโนโลยีปัจจุบันก็ตาม จากนั้นจึงจัดเก็บข้อมูลเหล่านี้ไว้เป็นระยะเวลานาน เพื่อรอวันที่คอมพิวเตอร์ควอนตัม (CRQC) มีความสามารถเพียงพอที่จะทำลายการเข้ารหัสที่ใช้ปกป้องข้อมูลเหล่านั้นได้.

กระบวนการโจมตีแบบ HNDL โดยทั่วไปประกอบด้วย 3 ขั้นตอนหลัก :

- การเก็บเกี่ยวข้อมูล (Data Harvest): ผู้โจมตีจะระบุเป้าหมายข้อมูลที่มีคุณค่าในระยะยาวและมีความอ่อนไหวสูง จากนั้นจึงใช้เทคนิคต่างๆ ในการดักจับข้อมูลที่เข้ารหัสขณะส่งผ่านเครือข่าย หรือขโมยข้อมูลที่จัดเก็บไว้ในเซิร์ฟเวอร์หรือฐานข้อมูล การเก็บเกี่ยวนี้อาจเกิดขึ้นอย่างต่อเนื่องและตรวจจับได้ยาก.

- การจัดเก็บข้อมูล (Data Storage): ข้อมูลที่ถูกขโมยมาจะถูกนำไปจัดเก็บอย่างปลอดภัย อาจเป็นเวลาหลายปีหรือหลายสิบปี ต้นทุนการจัดเก็บข้อมูลที่ลดลงทำให้การเก็บข้อมูลปริมาณมหาศาลเป็นไปได้. ผู้โจมตีอาจใช้เทคนิคการปกปิด เช่น การแยกส่วนไฟล์ หรือการตั้งชื่อไฟล์ที่ไม่สื่อความหมาย เพื่อหลีกเลี่ยงการตรวจพบ.

- การถอดรหัสในอนาคต (Future Decryption): เมื่อ CRQC พร้อมใช้งาน ผู้โจมตีจะนำข้อมูลที่เก็บไว้มาถอดรหัสโดยใช้อัลกอริทึมควอนตัม (เช่น Shor’s algorithm สำหรับข้อมูลที่เข้ารหัสด้วย RSA/ECC) เพื่อเข้าถึงข้อมูลลับที่อยู่ภายใน.

ข้อมูลประเภทที่ตกเป็นเป้าหมายหลักของ HNDL คือข้อมูลที่มี “อายุการใช้งานยาวนาน” (long shelf life) หรือยังคงมีความอ่อนไหวและมีคุณค่าแม้เวลาจะผ่านไปนาน. ตัวอย่างเช่น:

- ข้อมูลส่วนบุคคลที่ระบุตัวตนได้ (PII) เช่น หมายเลขบัตรประชาชน ข้อมูลทางการเงิน ประวัติสุขภาพ.

- ทรัพย์สินทางปัญญา (Intellectual Property – IP) เช่น ความลับทางการค้า สิทธิบัตร งานวิจัยและพัฒนา.

- ข้อมูลลับของรัฐบาลหรือทางการทหาร.

- ข้อมูลทางการเงินและกฎหมายระยะยาว.

สิ่งที่ทำให้ HNDL เป็นภัยคุกคาม ในปัจจุบัน ไม่ใช่ภัยคุกคามในอนาคต คือขั้นตอนการเก็บเกี่ยวข้อมูลสามารถเกิดขึ้นได้ ตั้งแต่วันนี้. ข้อมูลใดๆ ที่ถูกส่งหรือจัดเก็บในวันนี้โดยใช้การเข้ารหัสแบบกุญแจสาธารณะ (RSA, ECC) ที่อ่อนแอต่อการโจมตีด้วยควอนตัม ก็ตกอยู่ในความเสี่ยงที่จะถูกเปิดเผยในอนาคตทันทีที่ CRQC เกิดขึ้นจริง. มีข้อบ่งชี้ว่าหน่วยงานข่าวกรองของบางประเทศอาจกำลังดำเนินกลยุทธ์ HNDL อยู่แล้วในขณะนี้.

แนวคิด HNDL นี้เองที่สร้างแรงกดดันอย่างมหาศาลให้องค์กรต่างๆ ต้องเร่งดำเนินการเปลี่ยนผ่านไปสู่ PQC โดยเร็วที่สุด. การรอจนถึงวันที่ CRQC ปรากฏตัวจริง หรือที่เรียกว่า “Q-Day” แล้วค่อยเริ่มดำเนินการนั้นสายเกินไปสำหรับข้อมูลที่ถูกดักจับไปแล้วในวันนี้และต้องการการปกป้องความลับในระยะยาวเกินกว่ากรอบเวลาที่คาดว่า Q-Day จะมาถึง (ซึ่งอาจอยู่ภายใน 10-15 ปีข้างหน้า). ดังนั้น เส้นตายที่แท้จริงสำหรับการปกป้องข้อมูลที่มีความอ่อนไหวในระยะยาวจึงไม่ใช่ Q-Day ในอนาคต แต่เป็น ปัจจุบัน. การเปลี่ยนผ่านสู่ PQC จึงไม่ใช่แค่การเตรียมพร้อมสำหรับอนาคต แต่เป็นการแก้ไขช่องโหว่ที่มีอยู่แล้วในปัจจุบันสำหรับข้อมูลที่ต้องการความลับยืนยาว

2. เส้นทางสู่การต้านทานควอนตัม: การเข้ารหัสลับหลังยุคควอนตัม (PQC) (The Path to Quantum Resistance: Post-Quantum Cryptography (PQC))

2.1. ความจำเป็นในการนำ PQC มาใช้ (The Imperative for PQC Adoption)

ดังที่ได้กล่าวไปแล้ว แรงผลักดันหลักที่ทำให้ต้องมีการเปลี่ยนผ่านสู่การเข้ารหัสลับหลังยุคควอนตัม (Post-Quantum Cryptography – PQC) คือภัยคุกคามที่เกิดจาก Shor’s algorithm ต่อระบบการเข้ารหัสแบบกุญแจสาธารณะที่ใช้กันอย่างแพร่หลาย เช่น RSA, ECC และรูปแบบต่างๆ ของ Diffie-Hellman. ระบบเหล่านี้เป็นเสาหลักของความปลอดภัยในการสื่อสารผ่านอินเทอร์เน็ต ลายเซ็นดิจิทัล การยืนยันตัวตน และการทำธุรกรรมอิเล็กทรอนิกส์ หากระบบเหล่านี้ถูกทำลาย ผลกระทบต่อความลับ (confidentiality) และความสมบูรณ์ (integrity) ของข้อมูลดิจิทัลจะเป็นวงกว้างและรุนแรงอย่างยิ่ง.

PQC หรือที่เรียกว่า การเข้ารหัสที่ทนทานต่อควอนตัม (Quantum-Resistant Cryptography) หมายถึง อัลกอริทึมการเข้ารหัสที่ออกแบบมาเพื่อให้ทำงานได้บนคอมพิวเตอร์แบบดั้งเดิมในปัจจุบัน แต่เชื่อว่ามีความปลอดภัยเพียงพอที่จะต้านทานการโจมตีได้ทั้งจากคอมพิวเตอร์แบบดั้งเดิมและคอมพิวเตอร์ควอนตัมในอนาคต. สิ่งสำคัญคือต้องแยกแยะ PQC ออกจาก การเข้ารหัสควอนตัม (Quantum Cryptography) เช่น Quantum Key Distribution (QKD) ซึ่งใช้หลักการควอนตัมในการแลกเปลี่ยนกุญแจ แต่ไม่ได้แก้ปัญหาการเข้ารหัสข้อมูลหรือการสร้างลายเซ็นดิจิทัลโดยตรง และมักต้องการโครงสร้างพื้นฐานพิเศษ. PQC มุ่งเน้นไปที่การพัฒนาอัลกอริทึมใหม่ที่สามารถนำมาใช้ทดแทนอัลกอริทึมเดิมในโครงสร้างพื้นฐานปัจจุบันได้

ความจำเป็นในการเริ่มเปลี่ยนผ่านสู่ PQC โดยเร่งด่วนไม่ได้เกิดจากภัยคุกคามในอนาคตเพียงอย่างเดียว แต่ยังเกิดจากระยะเวลาที่ยาวนานในการปรับใช้มาตรฐานการเข้ารหัสใหม่ในอดีต. ตัวอย่างเช่น การเปลี่ยนจาก Data Encryption Standard (DES) ไปสู่ Triple DES และ Advanced Encryption Standard (AES) หรือการเลิกใช้ฟังก์ชันแฮช SHA-1 ล้วนใช้เวลานานหลายสิบปี. การรอจนกระทั่ง CRQC ปรากฏตัวจริงจึงค่อยเริ่มกระบวนการเปลี่ยนผ่านนั้นมีความเสี่ยงสูงเกินไป โดยเฉพาะอย่างยิ่งเมื่อพิจารณาถึงภัยคุกคามจาก HNDL.

เป้าหมายสำคัญประการหนึ่งของความพยายามในการสร้างมาตรฐาน PQC เช่น โครงการของ NIST คือการพัฒนาอัลกอริทึมที่สามารถทำงานร่วมกับโปรโตคอลและเครือข่ายการสื่อสารที่มีอยู่ได้ (interoperate with existing communications protocols and networks) เพื่อลดผลกระทบต่อระบบปัจจุบันให้น้อยที่สุด. อย่างไรก็ตาม การบรรลุเป้าหมายนี้ก็มีความท้าทายในทางปฏิบัติ อัลกอริทึม PQC หลายตัวมีขนาดของกุญแจและลายเซ็นที่ใหญ่กว่า RSA หรือ ECC อย่างมีนัยสำคัญ และอาจมีประสิทธิภาพในการคำนวณที่แตกต่างกัน ซึ่งส่งผลต่อค่าใช้จ่ายในการสื่อสาร (communication overhead) และความเร็วในการประมวลผล. แม้ว่าอัลกอริทึม PQC บางตัว เช่น Kyber และ Dilithium อาจมีประสิทธิภาพดีกว่า RSA และ ECDSA ที่ระดับความปลอดภัยคลาสสิกเทียบเท่ากัน แต่การนำไปใช้งานจริงยังคงต้องพิจารณาถึงผลกระทบเหล่านี้อย่างรอบคอบในการวางแผนการเปลี่ยนผ่าน

2.2. โครงการ PQC ของ NIST: กระบวนการและเป้าหมาย (The NIST PQC Standardization Initiative: Process and Goals)

สถาบันมาตรฐานและเทคโนโลยีแห่งชาติสหรัฐฯ (National Institute of Standards and Technology – NIST) ซึ่งมีบทบาทสำคัญในการออกมาตรฐานการเข้ารหัสลับที่ใช้กันทั่วโลก (เช่น AES, SHA-3, FIPS 186 สำหรับลายเซ็นดิจิทัล) ได้ตระหนักถึงภัยคุกคามจากคอมพิวเตอร์ควอนตัม และได้ริเริ่ม “โครงการสร้างมาตรฐานการเข้ารหัสลับหลังยุคควอนตัม” (Post-Quantum Cryptography Standardization Process) ขึ้นอย่างเป็นทางการราวปี 2016-2017.

เป้าหมายหลักของโครงการนี้คือการคัดเลือก ประเมิน และออกมาตรฐานสำหรับอัลกอริทึมการเข้ารหัสแบบกุญแจสาธารณะ (Public-Key Cryptography) อย่างน้อยหนึ่งอัลกอริทึม ที่มีความทนทานต่อการโจมตีจากทั้งคอมพิวเตอร์แบบดั้งเดิมและคอมพิวเตอร์ควอนตัม. อัลกอริทึมเหล่านี้จะต้องเป็นแบบไม่ลับ (unclassified) เปิดเผยต่อสาธารณะ (publicly disclosed) และสามารถใช้งานได้ทั่วโลก. โดยมุ่งเน้นไปที่สองฟังก์ชันหลักของการเข้ารหัสแบบกุญแจสาธารณะ คือ:

- การเข้ารหัสแบบกุญแจสาธารณะ / กลไกการห่อหุ้มกุญแจ (Public-Key Encryption / Key-Encapsulation Mechanisms – KEMs): สำหรับการสร้างและแลกเปลี่ยนกุญแจลับร่วมกันอย่างปลอดภัยผ่านช่องทางสาธารณะ เพื่อใช้ในการเข้ารหัสข้อมูลแบบสมมาตรต่อไป.

- ลายเซ็นดิจิทัล (Digital Signatures): สำหรับการยืนยันความถูกต้องของข้อมูล (integrity) และการพิสูจน์ตัวตนของผู้ลงนาม (authentication).

กระบวนการของ NIST เป็นแบบเปิดและโปร่งใส โดยเชิญชวนนักวิจัยและผู้เชี่ยวชาญด้านการเข้ารหัสลับจากทั่วโลกให้ส่งข้อเสนออัลกอริทึมเข้าร่วมการพิจารณา. กระบวนการคัดเลือกประกอบด้วยหลายรอบ (rounds) ของการประเมินผลและการวิเคราะห์ความปลอดภัยอย่างเข้มข้นโดยชุมชนนักวิจัยนานาชาติ :

- เปิดรับข้อเสนอ: สิ้นสุดเดือนพฤศจิกายน 2017.

- รอบที่ 1: คัดเลือกอัลกอริทึม 26 ตัว จาก 69 ข้อเสนอ เพื่อเข้าสู่รอบต่อไป สิ้นสุดเดือนมกราคม 2019.

- รอบที่ 2: คัดเลือกอัลกอริทึม 15 ตัว (7 ตัวเข้ารอบสุดท้าย และ 8 ตัวสำรอง) สิ้นสุดเดือนกรกฎาคม 2020.

- รอบที่ 3: ทำการวิเคราะห์เชิงลึกยิ่งขึ้น และประกาศอัลกอริทึมชุดแรกที่จะนำไปสร้างเป็นมาตรฐานในเดือนกรกฎาคม 2022.

- รอบที่ 4: ดำเนินการต่อสำหรับอัลกอริทึม KEM เพิ่มเติม โดย HQC ได้รับเลือกในเดือนมีนาคม 2025.

- การประกาศมาตรฐาน: ร่างมาตรฐาน FIPS ชุดแรก (FIPS 203, 204, 205) เผยแพร่เพื่อรับฟังความคิดเห็นในเดือนสิงหาคม 2023 และประกาศเป็นมาตรฐานฉบับสมบูรณ์ในเดือนสิงหาคม 2024. ร่างมาตรฐานสำหรับอัลกอริทึมลายเซ็นตัวที่สี่ (FALCON) คาดว่าจะเผยแพร่ในภายหลัง.

ลักษณะการดำเนินงานแบบหลายรอบ การคัดเลือกทั้งตัวจริงและตัวสำรอง และการเปิดรอบที่ 4 เพื่อพิจารณาอัลกอริทึมเพิ่มเติม สะท้อนให้เห็นถึงความซับซ้อนและความท้าทายในการค้นหาและตรวจสอบความปลอดภัยของอัลกอริทึม PQC NIST ตระหนักดีว่ากระบวนการนี้ต้องใช้เวลาและความระมัดระวัง เพื่อให้มั่นใจว่ามาตรฐานที่ออกมามีความน่าเชื่อถือและปลอดภัยในระยะยาว การที่ HQC ถูกเลือกเข้ามาในภายหลัง ยิ่งตอกย้ำว่ากระบวนการสร้างมาตรฐาน PQC เป็นกระบวนการที่ต่อเนื่องและมีการปรับปรุงอยู่เสมอ ไม่ใช่เหตุการณ์ที่เกิดขึ้นครั้งเดียวแล้วจบไป

2.3. อัลกอริทึม PQC ที่ได้มาตรฐาน (Standardized PQC Algorithms)

หลังจากกระบวนการคัดเลือกและประเมินผลที่ยาวนานหลายปี NIST ได้ประกาศมาตรฐาน PQC ชุดแรกในเดือนสิงหาคม 2024 ซึ่งประกอบด้วยอัลกอริทึม 3 ตัว. อัลกอริทึมเหล่านี้ได้รับการออกแบบมาเพื่อทดแทนการใช้งานหลักของการเข้ารหัสแบบกุญแจสาธารณะในปัจจุบัน

2.3.1. ML-KEM (Kyber / FIPS 203): การห่อหุ้มกุญแจ (Key Encapsulation)

- มาตรฐาน: FIPS 203, Module-Lattice-Based Key-Encapsulation Mechanism Standard.

- ที่มา: พัฒนามาจากอัลกอริทึม CRYSTALS-Kyber ซึ่งเป็นหนึ่งในผู้เข้ารอบสุดท้ายของ NIST.

- วัตถุประสงค์: ใช้สำหรับสร้างกุญแจลับร่วม (shared secret key) ระหว่างสองฝ่ายผ่านช่องทางสาธารณะอย่างปลอดภัย. ฝ่ายหนึ่งสร้างคู่กุญแจ (encapsulation key สาธารณะ และ decapsulation key ส่วนตัว) อีกฝ่ายใช้กุญแจสาธารณะเพื่อ “ห่อหุ้ม” (encapsulate) กุญแจลับร่วม สร้างเป็น ciphertext ส่งกลับไปให้อีกฝ่าย “แกะห่อ” (decapsulate) ด้วยกุญแจส่วนตัว. กุญแจลับร่วมที่ได้นี้จะถูกนำไปใช้กับการเข้ารหัสแบบสมมาตรต่อไป.

- พื้นฐานทางคณิตศาสตร์: ความปลอดภัยขึ้นอยู่กับความยากของปัญหา Module Learning With Errors (MLWE) บนโครงสร้างทางคณิตศาสตร์ที่เรียกว่า แลตทิซ (lattices).

- ชุดพารามิเตอร์: มี 3 ระดับความปลอดภัยมาตรฐาน :

- ML-KEM-512: ระดับความปลอดภัย 1 (เทียบเท่า AES-128 โดยประมาณ)

- ML-KEM-768: ระดับความปลอดภัย 3 (เทียบเท่า AES-192 โดยประมาณ)

- ML-KEM-1024: ระดับความปลอดภัย 5 (เทียบเท่า AES-256 โดยประมาณ)

- ลักษณะเด่น: ถูกกำหนดให้เป็นมาตรฐานหลักสำหรับ KEM. มีข้อดีคือขนาดกุญแจและ ciphertext ค่อนข้างเล็ก (เช่น ML-KEM-512 มี encapsulation key 800 ไบต์, decapsulation key 1632 ไบต์, ciphertext 768 ไบต์) และทำงานได้รวดเร็ว. ผลลัพธ์ที่ได้คือ shared secret key ขนาดคงที่ 256 บิต (32 ไบต์) สำหรับทุกระดับความปลอดภัย.

2.3.2. ML-DSA (Dilithium / FIPS 204): ลายเซ็นดิจิทัล (Digital Signatures)

- มาตรฐาน: FIPS 204, Module-Lattice-Based Digital Signature Standard.

- ที่มา: พัฒนามาจากอัลกอริทึม CRYSTALS-Dilithium ซึ่งเป็นผู้เข้ารอบสุดท้ายอีกตัวหนึ่ง.

- วัตถุประสงค์: ใช้สำหรับสร้าง (sign) และตรวจสอบ (verify) ลายเซ็นดิจิทัล เพื่อรับรองความถูกต้องสมบูรณ์ของข้อมูล (data integrity) และพิสูจน์ตัวตนของผู้ลงนาม (authenticity) รวมถึงให้คุณสมบัติการปฏิเสธความรับผิดชอบไม่ได้ (non-repudiation).

- พื้นฐานทางคณิตศาสตร์: ความปลอดภัยขึ้นอยู่กับความยากของปัญหาทางแลตทิซเช่นกัน (เช่น Module-LWE และ Module Short Integer Solution – SIS).

- ชุดพารามิเตอร์: มีหลายระดับความปลอดภัย เช่น ML-DSA-44 (ระดับ 2), ML-DSA-65 (ระดับ 3), ML-DSA-87 (ระดับ 5).

- ลักษณะเด่น: ถูกกำหนดให้เป็นมาตรฐานหลักสำหรับลายเซ็นดิจิทัล. มีข้อดีคือการสร้างกุญแจ การลงนาม และการตรวจสอบลายเซ็นทำได้รวดเร็ว. ขนาดกุญแจและลายเซ็นมีขนาดปานกลางเมื่อเทียบกับอัลกอริทึม PQC อื่นๆ.

2.3.3. SLH-DSA (SPHINCS+ / FIPS 205): ลายเซ็นแบบแฮชที่ไม่เก็บสถานะ (Stateless Hash-Based Signatures)

- มาตรฐาน: FIPS 205, Stateless Hash-Based Digital Signature Standard.

- ที่มา: พัฒนามาจากอัลกอริทึม SPHINCS+ (อ่านว่า “สฟิงซ์พลัส”).

- วัตถุประสงค์: ใช้สำหรับสร้างและตรวจสอบลายเซ็นดิจิทัลเช่นเดียวกับ ML-DSA.

- พื้นฐานทางคณิตศาสตร์: แตกต่างจาก ML-KEM และ ML-DSA อย่างสิ้นเชิง โดยความปลอดภัยของ SLH-DSA ขึ้นอยู่กับความปลอดภัยของฟังก์ชันแฮช (cryptographic hash functions) ที่ใช้เป็นพื้นฐานเท่านั้น (เช่น SHA-256 หรือ SHAKE256). ไม่ได้อาศัยปัญหาทางแลตทิซหรือปัญหาทางทฤษฎีจำนวนอื่นๆ ที่อาจถูกทำลายโดยคอมพิวเตอร์ควอนตัมได้

- ลักษณะเด่น: เป็นอัลกอริทึมแบบ “stateless” ซึ่งหมายความว่าผู้ลงนามไม่จำเป็นต้องจดจำสถานะ (เช่น จำนวนครั้งที่ใช้กุญแจไปแล้ว) เหมือนกับลายเซ็นแบบแฮชรุ่นเก่า (stateful hash-based signatures – HBS) เช่น LMS/HSS หรือ XMSS ทำให้ใช้งานง่ายและผิดพลาดได้ยากกว่า. ถูกกำหนดให้เป็นมาตรฐานสำรอง (backup) สำหรับลายเซ็นดิจิทัล เผื่อในกรณีที่อัลกอริทึมที่ใช้แลตทิซ (ML-DSA) ถูกค้นพบช่องโหว่ในอนาคต. ข้อเสียเปรียบหลักคือขนาดของลายเซ็นค่อนข้างใหญ่ (เช่น 17KB สำหรับ SPHINCS+ 256 128-bit) และประสิทธิภาพโดยรวม (ความเร็วในการสร้างกุญแจและลงนาม) ช้ากว่า ML-DSA อย่างมีนัยสำคัญ. มีชุดพารามิเตอร์ที่ให้เลือกระหว่างความเร็ว (‘f’ – fast) กับขนาดลายเซ็นที่เล็กลง (‘s’ – small).

การที่ NIST เลือกสร้างมาตรฐานอัลกอริทึม PQC ที่มาจากพื้นฐานทางคณิตศาสตร์ที่แตกต่างกัน (แลตทิซสำหรับ ML-KEM/ML-DSA และฟังก์ชันแฮชสำหรับ SLH-DSA) เป็นกลยุทธ์ที่สำคัญในการกระจายความเสี่ยง. หากในอนาคตมีการค้นพบวิธีการโจมตีที่มีประสิทธิภาพต่อปัญหาทางแลตทิซด้วยคอมพิวเตอร์ควอนตัมหรือคอมพิวเตอร์แบบดั้งเดิม อัลกอริทึม SLH-DSA ที่อาศัยความปลอดภัยของฟังก์ชันแฮชก็จะยังคงปลอดภัยอยู่ (ตราบเท่าที่ฟังก์ชันแฮชที่ใช้ยังปลอดภัย) การมีทางเลือกที่หลากหลายนี้ช่วยเพิ่มความมั่นใจในความปลอดภัยระยะยาวของโครงสร้างพื้นฐานการเข้ารหัสลับ

ตารางที่ 2: สรุปอัลกอริทึม PQC ที่ NIST กำหนดเป็นมาตรฐาน (ชุดแรก)

| มาตรฐาน FIPS | ชื่ออัลกอริทึม | ข้อเสนอเดิม | ประเภท | ปัญหาทางคณิตศาสตร์พื้นฐาน | ระดับความปลอดภัย | ลักษณะเด่น / ขนาด (ระดับ 3) |

|---|---|---|---|---|---|---|

| FIPS 203 | ML-KEM | CRYSTALS-Kyber | KEM | Module-LWE (Lattice) | 1, 3, 5 | KEM หลัก, เร็ว, ขนาดเล็ก (Enc Key: 1184 B, Dec Key: 2400 B, Ciphertext: 1088 B) |

| FIPS 204 | ML-DSA | CRYSTALS-Dilithium | Signature | Module-LWE/SIS (Lattice) | 2, 3, 5 | Signature หลัก, เร็ว (Pub Key: 1952 B, Priv Key: 4000 B, Sig: 3293 B) |

| FIPS 205 | SLH-DSA | SPHINCS+ | Signature | Hash Function Security | 1, 3, 5 | Signature สำรอง, Stateless, ปลอดภัยบนพื้นฐานแฮช, ขนาดใหญ่ (Pub Key: 64 B, Priv Key: 128 B, Sig: ~17 KB for 128f) |

หมายเหตุ: B = ไบต์ (Bytes), KB = กิโลไบต์ (Kilobytes). ขนาดที่แสดงเป็นตัวอย่างสำหรับระดับความปลอดภัยเทียบเท่า AES-192 (ระดับ 3 สำหรับ ML-KEM, ระดับ 3/ML-DSA-65 สำหรับ ML-DSA) หรือ AES-128 (ระดับ 1/SLH-DSA--128f สำหรับ SLH-DSA)*

ตารางนี้ช่วยให้เห็นภาพรวมของมาตรฐาน PQC ชุดแรกจาก NIST ทำให้สามารถเปรียบเทียบวัตถุประสงค์ ที่มา พื้นฐานทางคณิตศาสตร์ และลักษณะการใช้งานที่สำคัญของแต่ละอัลกอริทึม ซึ่งเป็นข้อมูลพื้นฐานที่จำเป็นสำหรับการตัดสินใจเลือกอัลกอริทึมที่เหมาะสมในระหว่างการวางแผนเปลี่ยนผ่าน

3. การเตรียมพร้อมสำหรับอนาคตควอนตัม: กลยุทธ์การเปลี่ยนผ่าน (Preparing for the Quantum Future: Migration Strategies)

การตระหนักถึงภัยคุกคามควอนตัมและการมีอยู่ของมาตรฐาน PQC เป็นเพียงจุดเริ่มต้น การเปลี่ยนผ่านระบบการเข้ารหัสลับที่มีอยู่ไปสู่ PQC เป็นกระบวนการที่ซับซ้อนและต้องใช้เวลา. องค์กรต่างๆ จำเป็นต้องมีการวางแผนเชิงรุกและดำเนินการอย่างเป็นระบบเพื่อจัดการกับความท้าทายนี้.

3.1. การสร้างแผนการเปลี่ยนผ่าน PQC: การสำรวจและการประเมินความเสี่ยง (Building a PQC Migration Roadmap: Inventory and Risk Assessment)

ขั้นตอนแรกที่สำคัญที่สุดในการเตรียมพร้อมคือการทำความเข้าใจสถานะปัจจุบันและประเมินความเสี่ยงเฉพาะขององค์กร. กระบวนการนี้ประกอบด้วยขั้นตอนหลักดังนี้:

- การสำรวจและจัดทำบัญชีรายการสินทรัพย์การเข้ารหัส (Cryptographic Inventory): องค์กรต้องระบุให้ได้ว่ามีการใช้งานการเข้ารหัสลับประเภทใดบ้าง (โดยเฉพาะ RSA, ECC และอัลกอริทึมกุญแจสาธารณะอื่นๆ) ใช้อยู่ที่ไหนในระบบ แอปพลิเคชัน หรือโปรโตคอลต่างๆ และใช้เพื่อวัตถุประสงค์ใด. ขั้นตอนนี้มักเป็นขั้นตอนที่ท้าทายที่สุด เนื่องจากระบบเดิมอาจมีการใช้งานการเข้ารหัสที่ไม่ได้บันทึกไว้ หรืออาจมีการพึ่งพาไลบรารีหรือบริการจากภายนอก. การมีบัญชีรายการที่สมบูรณ์และถูกต้องเป็นพื้นฐานสำคัญอย่างยิ่งสำหรับการประเมินความเสี่ยงและการวางแผนต่อไป.

- การประเมินความเสี่ยงควอนตัม (Quantum Risk Assessment): เมื่อทราบว่ามีการใช้งานการเข้ารหัสที่ใดบ้าง ขั้นต่อไปคือการประเมินว่าระบบหรือข้อมูลใดมีความเสี่ยงต่อการโจมตีด้วยควอนตัม. ปัจจัยสำคัญที่ต้องพิจารณาคือ “อายุความลับที่ต้องการ” (required security lifetime) ของข้อมูล เทียบกับกรอบเวลาที่คาดการณ์ว่า CRQC จะพร้อมใช้งาน. ต้องคำนึงถึงภัยคุกคาม HNDL เป็นพิเศษสำหรับข้อมูลที่ต้องการการปกป้องในระยะยาว (เช่น 10-20 ปีขึ้นไป). ผลการประเมินความเสี่ยงจะช่วยในการจัดลำดับความสำคัญของระบบที่ต้องทำการเปลี่ยนผ่านก่อน.

- การพัฒนาแผนการเปลี่ยนผ่าน (Migration Plan Development): จากข้อมูลการสำรวจและประเมินความเสี่ยง องค์กรจะต้องกำหนดแผนการเปลี่ยนผ่านที่ชัดเจน ซึ่งควรรวมถึง:

- การกำหนดกรอบเวลาและทรัพยากร: กำหนดเป้าหมายระยะสั้นและระยะยาว จัดสรรงบประมาณและบุคลากร.

- การเลือกอัลกอริทึม PQC: เลือกอัลกอริทึม PQC ที่เหมาะสมจากมาตรฐาน (เช่น NIST FIPS) โดยพิจารณาจากระดับความปลอดภัยที่ต้องการ ประสิทธิภาพ ขนาดกุญแจ/ลายเซ็น และความเหมาะสมกับแต่ละแอปพลิเคชัน.

- การกำหนดกลยุทธ์การปรับใช้: ตัดสินใจว่าจะใช้แนวทางใด เช่น การเปลี่ยนผ่านโดยตรง การใช้ hybrid cryptography หรือการมุ่งเน้นที่ crypto-agility.

- การวางแผนทดสอบและตรวจสอบ: กำหนดขั้นตอนการทดสอบนำร่อง (pilot testing) การตรวจสอบความเข้ากันได้ (interoperability testing) และการประเมินประสิทธิภาพก่อนการปรับใช้จริง.

- การพิจารณาข้อกำหนดและกฎระเบียบ: ตรวจสอบว่ามีข้อกำหนดทางกฎหมายหรือข้อบังคับเฉพาะอุตสาหกรรมที่เกี่ยวข้องกับการเปลี่ยนผ่าน PQC หรือไม่.

ตารางที่ 3: ขั้นตอนสำคัญในการวางแผนการเปลี่ยนผ่านสู่ PQC

| ระยะ (Phase) | การดำเนินการหลัก (Key Actions) | ข้อควรพิจารณา (Key Considerations) |

|---|---|---|

| 1: การวินิจฉัย (Diagnosis) | – จัดทำบัญชีรายการสินทรัพย์การเข้ารหัส (Inventory) <br> – ประเมินความเสี่ยงควอนตัม & จัดลำดับความสำคัญ (Risk Assessment & Prioritization) | – เครื่องมือช่วยสำรวจ (Discovery tools) <br> – ความอ่อนไหวและอายุความลับของข้อมูล (HNDL) <br> – การพึ่งพา Vendor/Third-party |

| 2: การวางแผน (Planning) | – เลือกอัลกอริทึม PQC (Algorithm Selection) <br> – กำหนดกลยุทธ์ (Strategy Definition: Hybrid/Agility) <br> – ทดสอบนำร่อง (Pilot Testing) <br> – วางแผนทรัพยากร (Resource Planning) | – ความต้องการด้านประสิทธิภาพ (Performance needs) <br> – ความเข้ากันได้ (Interoperability) <br> – ความพร้อมของ Vendor (Vendor readiness) <br> – การออกแบบเพื่อ Crypto-agility |

| 3: การดำเนินการ (Execution) | – การนำไปใช้และปรับใช้ (Implementation & Deployment) <br> – การตรวจสอบความถูกต้อง (Validation) <br> – การเฝ้าระวังและบำรุงรักษา (Monitoring & Maintenance) | – แผนการ Rollback <br> – การฝึกอบรมบุคลากร <br> – การเฝ้าระวังช่องโหว่ใหม่ <br> – การปรับปรุงอย่างต่อเนื่อง |

Export to Sheets

การจัดทำบัญชีรายการสินทรัพย์การเข้ารหัสถือเป็นรากฐานสำคัญและมักเป็นส่วนที่ท้าทายที่สุดของการเตรียมการ. หากปราศจากความเข้าใจที่ชัดเจนว่าองค์กรใช้อัลกอริทึมใด ที่ไหน และทำไม การประเมินความเสี่ยงที่แม่นยำและการวางแผนเปลี่ยนผ่านที่มีประสิทธิภาพย่อมเป็นไปไม่ได้. การลงทุนในเครื่องมือและกระบวนการเพื่อสร้างและดูแลรักษาบัญชีรายการนี้ให้เป็นปัจจุบันจึงเป็น “การลงทุนที่ไม่สูญเปล่า” (no-regret move) ที่จะช่วยเพิ่มความสามารถในการรับมือกับความท้าทายด้านการเข้ารหัสลับอื่นๆ ในอนาคตด้วย.

3.2. การเข้ารหัสแบบผสมผสาน: แนวทางในช่วงเปลี่ยนผ่าน (Hybrid Cryptography: A Transitional Approach)

เนื่องจากอัลกอริทึม PQC ยังถือว่าค่อนข้างใหม่ และอาจมีช่องโหว่ที่ไม่คาดคิดถูกค้นพบในอนาคต แนวทางหนึ่งที่ได้รับความสนใจคือ การเข้ารหัสแบบผสมผสาน (Hybrid Cryptography). แนวคิดนี้คือการรวมเอาอัลกอริทึมการเข้ารหัสแบบดั้งเดิม (เช่น ECDH หรือ RSA สำหรับการแลกเปลี่ยนกุญแจ, ECDSA หรือ RSA สำหรับลายเซ็น) เข้ากับอัลกอริทึม PQC ที่มีฟังก์ชันเทียบเท่ากัน (เช่น ML-KEM สำหรับการแลกเปลี่ยนกุญแจ, ML-DSA สำหรับลายเซ็น).

เป้าหมายหลักของแนวทางผสมผสานคือการสร้างระบบที่ยังคงความปลอดภัยตราบเท่าที่ อย่างน้อยหนึ่ง ในสองอัลกอริทึม (ดั้งเดิมหรือ PQC) ยังคงปลอดภัย. กล่าวคือ:

- หากอัลกอริทึม PQC ที่เลือกใช้ถูกค้นพบว่ามีช่องโหว่ในภายหลัง ระบบก็จะยังคงปลอดภัยจากการโจมตีแบบดั้งเดิมด้วยอัลกอริทึมดั้งเดิมที่ใช้ร่วมกัน

- หากอัลกอริทึมดั้งเดิมถูกทำลายโดยคอมพิวเตอร์ควอนตัม ระบบก็จะยังคงปลอดภัยด้วยอัลกอริทึม PQC ที่ใช้ร่วมกัน

แนวทางนี้มีประโยชน์อย่างยิ่งในช่วงเปลี่ยนผ่าน ซึ่งความเชื่อมั่นในความปลอดภัยระยะยาวของอัลกอริทึม PQC ที่เพิ่งออกมาตรฐานยังคงอยู่ในช่วงพัฒนา. มันช่วยลดความเสี่ยงจากการเปลี่ยนไปใช้อัลกอริทึมใหม่ทั้งหมดในทันที. หน่วยงานกำกับดูแลและองค์กรในภาคส่วนที่อ่อนไหว เช่น การเงิน การดูแลสุขภาพ และการป้องกันประเทศ กำลังพิจารณาหรือเริ่มใช้แนวทางผสมผสานนี้แล้ว. NIST เองก็ยอมรับว่าแนวทางผสมผสานเป็นกลยุทธ์หนึ่งที่เป็นไปได้ , และโครงการ Open Quantum Safe ก็แนะนำให้พิจารณาใช้แนวทางนี้เพื่อบริหารความเสี่ยง.

อย่างไรก็ตาม แนวทางการเข้ารหัสแบบผสมผสานก็มีข้อเสียและข้อควรพิจารณา :

- ค่าใช้จ่ายในการคำนวณ (Computational Overhead): การรันอัลกอริทึมสองตัวย่อมใช้ทรัพยากรในการประมวลผลมากกว่าการรันอัลกอริทึมตัวเดียว ซึ่งอาจส่งผลกระทบต่อประสิทธิภาพของระบบ โดยเฉพาะในอุปกรณ์ที่มีทรัพยากรจำกัด

- ขนาดข้อมูลที่เพิ่มขึ้น (Increased Data Size): การส่งข้อมูลกุญแจสาธารณะหรือลายเซ็นที่เกิดจากการรวมกันของสองอัลกอริทึมจะทำให้ขนาดข้อมูลที่ต้องส่งผ่านเครือข่ายใหญ่ขึ้น

- ความซับซ้อนในการจัดการ (Management Complexity): การจัดการกุญแจและการกำหนดค่าสำหรับสองอัลกอริทึมพร้อมกันมีความซับซ้อนมากกว่า

- อาจต้องมีการเปลี่ยนผ่านครั้งที่สอง (Potential Second Transition): เมื่ออัลกอริทึม PQC ได้รับการยอมรับและเชื่อถืออย่างกว้างขวางแล้ว องค์กรอาจจำเป็นต้องทำการเปลี่ยนผ่านอีกครั้งเพื่อลบอัลกอริทึมดั้งเดิมออกไป เพื่อลดความซับซ้อนและค่าใช้จ่าย

ดังนั้น การเข้ารหัสแบบผสมผสานจึงถูกมองว่าเป็น “สะพาน” (bridge) ที่ช่วยให้ข้ามผ่านช่วงเวลาแห่งความไม่แน่นอนในการเปลี่ยนผ่านไปสู่ PQC ได้อย่างปลอดภัยมากขึ้น แต่ไม่ใช่ “จุดหมายปลายทาง” (destination) สุดท้าย. มันเป็นเครื่องมือบริหารความเสี่ยงที่มีค่าในช่วงเปลี่ยนผ่าน แต่ท้ายที่สุดแล้ว เป้าหมายระยะยาวคือการเปลี่ยนไปใช้ PQC อย่างเต็มรูปแบบเมื่อมาตรฐานมีความมั่นคงและเป็นที่ยอมรับอย่างกว้างขวาง

3.3. การบรรลุความคล่องตัวในการเข้ารหัสลับเพื่อความยืดหยุ่นในอนาคต (Achieving Crypto-Agility for Future Resilience)

แนวคิดที่สำคัญอย่างยิ่งในการรับมือกับการเปลี่ยนแปลงด้านการเข้ารหัสลับ ไม่ว่าจะเป็นการเปลี่ยนผ่านสู่ PQC หรือการรับมือกับช่องโหว่ใหม่ๆ ในอนาคต คือ ความคล่องตัวในการเข้ารหัสลับ (Crypto-Agility). Crypto-Agility หมายถึง ความสามารถของระบบสารสนเทศในการปรับเปลี่ยนหรือทดแทนอัลกอริทึมการเข้ารหัส พารามิเตอร์ หรือส่วนประกอบพื้นฐาน (cryptographic primitives) ได้อย่างมีประสิทธิภาพ โดยไม่ส่งผลกระทบอย่างรุนแรงต่อการทำงานของระบบ หรือต้องมีการปรับแก้สถาปัตยกรรมครั้งใหญ่.

ความสำคัญของ Crypto-Agility มีมากกว่าแค่การเปลี่ยนผ่านสู่ PQC มันเป็นหลักการออกแบบที่ช่วยให้องค์กรสามารถ:

- ตอบสนองต่อช่องโหว่ใหม่ได้อย่างรวดเร็ว: หากอัลกอริทึมที่ใช้อยู่ถูกค้นพบว่ามีช่องโหว่ร้ายแรง ระบบที่มีความคล่องตัวจะสามารถเปลี่ยนไปใช้อัลกอริทึมอื่นที่ปลอดภัยกว่าได้เร็วขึ้น.

- ปรับตัวตามมาตรฐานที่เปลี่ยนแปลง: เมื่อมีมาตรฐานการเข้ารหัสใหม่ที่ดีกว่าหรือปลอดภัยกว่าออกมา องค์กรสามารถอัปเกรดระบบได้ง่ายขึ้น.

- ลดต้นทุนและความซับซ้อนในการเปลี่ยนผ่าน: การออกแบบโดยคำนึงถึงความคล่องตัวตั้งแต่ต้น จะทำให้การเปลี่ยนผ่านในอนาคต (เช่น การเปลี่ยนจาก Hybrid ไป PQC ล้วน) ทำได้ง่ายและมีค่าใช้จ่ายน้อยลง.

การบรรลุ Crypto-Agility ในทางเทคนิคเกี่ยวข้องกับการปฏิบัติดังนี้ :

- การออกแบบแบบโมดูล (Modular Design): แยกส่วนที่เกี่ยวข้องกับการเข้ารหัสออกจากส่วนอื่นๆ ของแอปพลิเคชันหรือระบบ ทำให้สามารถเปลี่ยนโมดูลการเข้ารหัสได้โดยไม่กระทบส่วนอื่น

- หลีกเลี่ยงการ Hard-code: ไม่ควรระบุชื่ออัลกอริทึมหรือพารามิเตอร์การเข้ารหัสตายตัวลงในโค้ดโปรแกรม ควรใช้การกำหนดค่า (configuration) หรือกลไกอื่นที่ยืดหยุ่นกว่า

- ใช้โปรโตคอลที่รองรับการเจรจาอัลกอริทึม (Algorithm Negotiation): โปรโตคอลมาตรฐาน เช่น TLS (Transport Layer Security) มีกลไกให้คู่สื่อสารสามารถตกลงเลือกใช้อัลกอริทึมการเข้ารหัสที่ทั้งสองฝ่ายรองรับได้ ควรใช้ประโยชน์จากกลไกเหล่านี้

- การใช้ Abstraction Layers: ใช้ไลบรารีหรือ Application Programming Interfaces (APIs) ที่เป็นนามธรรม (abstract) เพื่อซ่อนรายละเอียดการใช้งานอัลกอริทึมเฉพาะ ทำให้สามารถเปลี่ยนอัลกอริทึมเบื้องหลังได้ง่ายขึ้น

การลงทุนในการสร้าง Crypto-Agility ในวันนี้ ไม่เพียงแต่จะช่วยให้การเปลี่ยนผ่านสู่ PQC เป็นไปอย่างราบรื่นขึ้นเท่านั้น แต่ยังเป็นการสร้างรากฐานความปลอดภัยที่ยืดหยุ่นและพร้อมรับมือกับการเปลี่ยนแปลงในระยะยาว. มันคือการปรับเปลี่ยนมุมมองจากการใช้การเข้ารหัสแบบคงที่ ไปสู่การจัดการการเข้ารหัสแบบพลวัต ซึ่งเป็นแนวทางปฏิบัติที่ดีที่สุดสำหรับความมั่นคงปลอดภัยทางไซเบอร์ในยุคปัจจุบันและอนาคต.

3.4. การใช้ประโยชน์จากเครื่องมือที่มีอยู่: Open Quantum Safe (OQS) และ liboqs (Leveraging Available Tools: Open Quantum Safe (OQS) and liboqs)

เพื่อช่วยให้นักพัฒนา นักวิจัย และองค์กรต่างๆ สามารถทดลอง เรียนรู้ และเตรียมพร้อมสำหรับการเปลี่ยนผ่านสู่ PQC ได้ง่ายขึ้น มีโครงการโอเพนซอร์สที่สำคัญเกิดขึ้นคือ Open Quantum Safe (OQS). OQS เป็นโครงการที่มุ่งสนับสนุนการพัฒนาและการสร้างต้นแบบ (prototyping) ของการเข้ารหัสที่ทนทานต่อควอนตัม และเป็นส่วนหนึ่งของ Post-Quantum Cryptography Alliance ภายใต้ Linux Foundation.

หัวใจหลักของโครงการ OQS คือ liboqs ซึ่งเป็นไลบรารีภาษา C แบบโอเพนซอร์สที่รวบรวมการ υλοποίηση (implementation) ของอัลกอริทึม PQC ประเภท KEM และลายเซ็นดิจิทัลจำนวนมาก รวมถึงอัลกอริทึมที่เข้าร่วมการพิจารณาของ NIST และอัลกอริทึมที่ได้รับเลือกเป็นมาตรฐานแล้ว. liboqs มีจุดเด่นคือ:

- API กลาง: มี Application Programming Interface (API) ที่เป็นมาตรฐานเดียวกันสำหรับอัลกอริทึมต่างๆ ทำให้ง่ายต่อการสลับเปลี่ยนและทดลองใช้อัลกอริทึมที่แตกต่างกัน.

- รองรับหลายแพลตฟอร์ม: สามารถคอมไพล์และใช้งานได้บนระบบปฏิบัติการหลัก (Linux, macOS, Windows) และสถาปัตยกรรมซีพียูที่หลากหลาย (x86_64, ARM).

- เครื่องมือทดสอบและวัดประสิทธิภาพ: มีชุดทดสอบ (test harness) และเครื่องมือวัดประสิทธิภาพ (benchmarking routines) เพื่อเปรียบเทียบอัลกอริทึมต่างๆ ภายใต้กรอบการทำงานเดียวกัน.

นอกเหนือจาก liboqs แล้ว โครงการ OQS ยังพัฒนาและดูแลรักษาการผนวกรวม (integrations) ไลบรารีนี้เข้ากับโปรโตคอลและแอปพลิเคชันที่ใช้กันอย่างแพร่หลาย เพื่อสาธิตและทดสอบการใช้งาน PQC ในสภาพแวดล้อมที่ใกล้เคียงความเป็นจริงมากขึ้น. ตัวอย่างการผนวกรวมที่สำคัญ ได้แก่:

- OpenSSL: ผ่าน oqs-provider สำหรับ OpenSSL 3.

- BoringSSL: (ไลบรารี TLS ที่พัฒนาโดย Google).

- OpenSSH: สำหรับการแลกเปลี่ยนกุญแจและการยืนยันตัวตนใน SSH.

- Language Wrappers: มีการพัฒนา wrapper เพื่อให้สามารถเรียกใช้ฟังก์ชันใน liboqs จากภาษาโปรแกรมอื่นๆ เช่น Rust, Java, Python, Go.

- Docker Images: มี Docker image ที่สร้างไว้ล่วงหน้า ทำให้ง่ายต่อการทดลองใช้ OpenSSL/curl, Apache httpd, และ nginx เวอร์ชันที่รองรับ PQC.

โครงการโอเพนซอร์สอย่าง OQS มีบทบาทสำคัญอย่างยิ่งในการเร่งกระบวนการสำรวจและปรับใช้ PQC. การมีเครื่องมือที่เข้าถึงได้ง่าย ช่วยลดอุปสรรคสำหรับนักวิจัย นักพัฒนา และองค์กรในการทดลอง ประเมิน และท้ายที่สุดคือการนำอัลกอริทึม PQC ไปใช้งานจริง การทดสอบและการให้ข้อเสนอแนะจากชุมชนในวงกว้างผ่านโครงการเหล่านี้ยังช่วยในการระบุปัญหาและสร้างความเชื่อมั่นในอัลกอริทึมใหม่ๆ ก่อนที่จะมีการนำไปใช้อย่างแพร่หลาย อย่างไรก็ตาม OQS เน้นย้ำว่าไลบรารีและเครื่องมือเหล่านี้มีวัตถุประสงค์หลักเพื่อการวิจัยและการสร้างต้นแบบ และยังไม่แนะนำให้ใช้ในสภาพแวดล้อมการทำงานจริง (production environment) สำหรับข้อมูลที่ละเอียดอ่อนในขณะนี้.

4. สรุปและข้อเสนอแนะเชิงกลยุทธ์ (Conclusion and Strategic Recommendations)

ภัยคุกคามจากการถือกำเนิดของคอมพิวเตอร์ควอนตัมต่อระบบการเข้ารหัสลับที่ใช้งานอยู่ในปัจจุบัน โดยเฉพาะอย่างยิ่งต่อโครงสร้างพื้นฐานกุญแจสาธารณะ (PKI) ที่อาศัยอัลกอริทึม RSA และ ECC เป็นเรื่องจริงจังและใกล้ตัวกว่าที่หลายคนคิด อัลกอริทึมของ Shor มีศักยภาพที่จะทำลายความปลอดภัยของระบบเหล่านี้ได้อย่างสิ้นเชิง ในขณะที่อัลกอริทึมของ Grover ก็ลดทอนความแข็งแกร่งของการเข้ารหัสแบบสมมาตร เช่น AES ลงอย่างมีนัยสำคัญ กลยุทธ์ “Harvest Now, Decrypt Later” (HNDL) ยิ่งเพิ่มความเร่งด่วนในการดำเนินการ เนื่องจากข้อมูลที่ถูกดักจับในวันนี้อาจถูกถอดรหัสได้ในอนาคต ทำให้การรอจนถึงวันที่คอมพิวเตอร์ควอนตัมสมบูรณ์แบบ (Q-Day) ไม่ใช่ทางเลือกที่ปลอดภัยสำหรับข้อมูลที่ต้องการการปกป้องในระยะยาว

โชคดีที่ความพยายามในการพัฒนาและสร้างมาตรฐานการเข้ารหัสลับหลังยุคควอนตัม (PQC) ได้มีความคืบหน้าอย่างมาก โดยเฉพาะอย่างยิ่งโครงการของ NIST ที่ได้เผยแพร่มาตรฐาน PQC ชุดแรก (FIPS 203 ML-KEM/Kyber, FIPS 204 ML-DSA/Dilithium, FIPS 205 SLH-DSA/SPHINCS+) ในเดือนสิงหาคม 2024 แล้ว ทำให้องค์กรต่างๆ มีแนวทางและอัลกอริทึมที่เป็นรูปธรรมในการเริ่มต้นกระบวนการเปลี่ยนผ่าน

อย่างไรก็ตาม การเปลี่ยนผ่านสู่ PQC เป็นกระบวนการที่ซับซ้อนและต้องใช้เวลา ไม่ใช่เรื่องที่จะทำสำเร็จได้ในชั่วข้ามคืน ประวัติศาสตร์การเปลี่ยนผ่านเทคโนโลยีการเข้ารหัสในอดีต , ความท้าทายในการสำรวจและทำความเข้าใจระบบเดิม , กระบวนการสร้างมาตรฐานที่ยังคงดำเนินต่อไป , และความจำเป็นในการสร้างความคล่องตัวในการเข้ารหัส ล้วนชี้ให้เห็นว่าการเปลี่ยนผ่าน PQC เปรียบเสมือน “การวิ่งมาราธอน ไม่ใช่การวิ่งระยะสั้น” ที่ต้องอาศัยความมุ่งมั่น ทรัพยากร และการวางแผนอย่างต่อเนื่องในระยะยาวจากทุกองค์กร.

เพื่อให้องค์กรสามารถรับมือกับความท้าทายนี้ได้อย่างมีประสิทธิภาพ มีข้อเสนอแนะเชิงกลยุทธ์ที่สำคัญดังต่อไปนี้:

- ลงมือทำทันที (Act Now): อย่ารอช้าจนถึง Q-Day เริ่มต้นกระบวนการด้วยการสำรวจและจัดทำบัญชีรายการสินทรัพย์การเข้ารหัส และประเมินความเสี่ยงควอนตัมโดยทันที โดยเฉพาะอย่างยิ่งเมื่อคำนึงถึงภัย HNDL.

- จัดลำดับความสำคัญ (Prioritize): มุ่งเน้นความพยายามในช่วงแรกไปยังระบบและข้อมูลที่มีความอ่อนไหวสูง ต้องการการปกป้องในระยะยาว และพึ่งพิง RSA/ECC สำหรับการแลกเปลี่ยนกุญแจหรือลายเซ็นดิจิทัลเป็นหลัก

- วางแผนเพื่อความคล่องตัว (Plan for Agility): ออกแบบหรือปรับปรุงระบบโดยคำนึงถึงหลักการ Crypto-Agility เพื่อให้การเปลี่ยนผ่านสู่ PQC ในปัจจุบัน และการปรับเปลี่ยนอื่นๆ ในอนาคต เป็นไปอย่างราบรื่นและมีประสิทธิภาพ.

- พิจารณาแนวทางผสมผสาน (อย่างรอบคอบ) (Consider Hybrid (Carefully)): ประเมินความเป็นไปได้และผลกระทบของการใช้ Hybrid Cryptography เป็นกลยุทธ์บริหารความเสี่ยงชั่วคราวในช่วงเปลี่ยนผ่าน โดยเฉพาะสำหรับระบบที่มีความสำคัญสูง.

- ปฏิบัติตามมาตรฐาน (Follow Standards): วางแผนการเปลี่ยนผ่านโดยใช้อัลกอริทึมที่ได้รับการรับรองเป็นมาตรฐาน เช่น อัลกอริทึมจาก NIST เพื่อให้มั่นใจในความปลอดภัยและความเข้ากันได้.

- ประสานงานกับผู้จำหน่าย (Engage Vendors): สอบถามและหารือเกี่ยวกับแผนงานและความพร้อมในการรองรับ PQC ของผู้จำหน่ายซอฟต์แวร์และฮาร์ดแวร์ที่องค์กรใช้งานอยู่

- ใช้ประโยชน์จากเครื่องมือ (Leverage Tools): ใช้ทรัพยากรโอเพนซอร์ส เช่น โครงการ Open Quantum Safe (OQS) และไลบรารี liboqs เพื่อช่วยในการสร้างต้นแบบ ทดสอบ และทำความเข้าใจอัลกอริทึม PQC.

- ติดตามข้อมูลข่าวสาร (Stay Informed): เฝ้าติดตามความคืบหน้าล่าสุดจาก NIST, หน่วยงานความมั่นคงปลอดภัยไซเบอร์ระดับสากล (เช่น ENISA ) และระดับชาติ (เช่น ANSSI ของฝรั่งเศส, BSI ของเยอรมนี, NCSC ของสหราชอาณาจักร ) รวมถึงงานวิจัยใหม่ๆ ในแวดวง PQC อย่างสม่ำเสมอ

โดยสรุป การเปลี่ยนผ่านสู่การเข้ารหัสลับหลังยุคควอนตัมเป็นความท้าทายทางเทคนิคและองค์กรที่สำคัญ แต่ก็เป็นสิ่งที่หลีกเลี่ยงไม่ได้เพื่อรักษาความมั่นคงปลอดภัยของข้อมูลในระยะยาว การวางแผนเชิงรุก การดำเนินการอย่างมีกลยุทธ์ และความมุ่งมั่นอย่างต่อเนื่อง จะเป็นกุญแจสำคัญสำหรับองค์กรในการนำทางผ่านความท้าทายนี้และก้าวเข้าสู่ยุคควอนตัมได้อย่างมั่นคงและปลอดภัย

Comments are closed